Vom 11. bis 13. Dezember 2018 fand die KubeCon & CloudNativeCon CNFC Konferenz in Seattle statt. Puzzle ist seit kurzem Mitglied der Cloud Native Computing Foundation (CNCF) und durfte an diesem Event teilnehmen. Sebastian Plattner fuhr nach Seattle und erzählt nun in seinem Blogpost von seinen Erlebnissen.

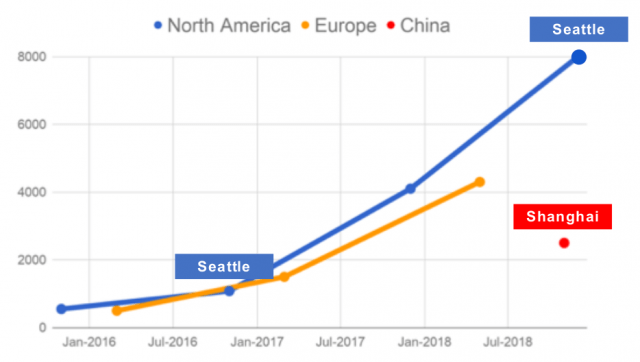

Die KubeCon & CloudNativeCon gab es in diesem Jahr in dreifacher Ausführung: Europe (im Mai in Kopenhagen), China (im November in Shanghai) und North America (im Dezember in Seattle). Mit über 8000 Besucher war Konferenz in Seattle die bisher bestbesuchte KubeCon & CloudNativeCon.

Die Community rund um Kubernetes ist stark am wachsen. Kubernetes (k8s) ist der defacto Standard für Container Orchestration. Viele grosse Vendors setzen auf Kubernetes (Google, Microsoft, IBM, Red Hat, Cisco, AWS, VMWARE etc).

Die KubeCon & CloudNativeCon Seattle war im Seattle Washington Conference Center zu Gast. Ich persönlich finde diese Konferenz-Zentren aufgrund ihrer Grösse immer wieder beeindruckend. Hier einen Eindruck der Halle, in der die Keynotes stattgefunden haben:

Nebst den vielen Tracks mit Talks zu diversen Themen rund um Kubernetes, gab es auch eine grosse Halle mit allen Sponsoren und deren ShowCases. Für Swag war also gesorgt 🙂

Eine KeyNote, die ich erwähnen will, ist der Talk von Kelsey Hightower. Kelsey ist bekannt für seine Live Demos und in seiner Keynote widmete er sich dem Thema „Serverless“. Dabei hat er ein altes und sehr einfaches Fortran Programm verwendet, um dieses Serverless auf Google Cloud Function sowie AWS Lambda zu betreiben. Er zeigt hier auf eine witzige Art und Weise („What, you don’t have Sound in your CLI Tools?“) seine genialen Engineering Fähigkeiten und demonstrierte die Serverless Funktionalität vendor-übergreifend.

Nebst der Konferenz hatte ich auch Gelegenheit Seattle etwas anzuschauen. Am Mittwochabend war z.B. die All Attendee Party (Sponsored by MongoDB & Tigera). Im Rahmen dieses Anlasses wurde der ganze Space Needle, das Museum of Pop Culture (MoPOP) und das Chihuly Garden and Glass Museam gemietet. Dabei konnte ich die Aussicht über Seattle von Top des Space Needle bestaunen und durch die Infinite worlds of Science Fiction im MoPOP laufen.

Alle Talks der Kubecon & CloudNativeCon 2018 und auch die Talks der OpenShift Commons Gathering können auf YouTube angeschaut werden.

Disclaimer: Über diese Themen könnte wohl unendlich berichtet werden. Da diese grosse Vielfalt jedoch nicht in einem Blogpost zusammengefasst werden kann, können als Einstieg die Talks angeschaut werden (insbesondere die Intro Talks). Wer mehr zu einem Thema erfahren will, schaut sich am Besten noch die Deep Dive Talks an.

Red Hat Operator Framework & OpenShift 4

Operator Framework

Red Hat war an der KubeCon&CloudNativeCon hauptsächlich mit dem Thema Operator Framework und OpenShift4 präsent. Operators sind ein Konzept das ursprünglich von CoreOS entwickelt wurde.

An Operator is a method of packaging, deploying and managing a Kubernetes application. A Kubernetes application is an application that is both deployed on Kubernetes and managed using the Kubernetes APIs and kubectl tooling. To be able to make the most of Kubernetes, you need a set of cohesive APIs to extend in order to service and manage your applications that run on Kubernetes. You can think of Operators as the runtime that manages this type of application on Kubernetes.

Mit dem Operator Framework bietet Red Hat ein OpenSource Toolkit an, um Kubernetes Native Applications effektiv, automatisiert und in skalierender Weise zu managen. Das Operator Framework besteht aus:

- Operator SDK SDK for building Kubernetes applications. Provides high level APIs, useful abstractions, and project scaffolding

Red Hat will hier eine standardisierte Vorgehensweise zum Erstellen von Operatoren ermöglichen. Mit dem Operator Framework bietet Red Hat u.A. ein CLI zum Initialisieren eines neuen Operators an. Dieser erstellt automatisch alle benötigten Ressourcen (Go Files, YAML Files für Deployment, YAML Files für CRD’s etc). Anschliessend muss „nur“ noch die Business Logik des Operators implementiert werden.

Der Operator Lifecycle Manager ist ein Operator für Operators. Red Hat stellt hier ein Tool zur Verfügung, um, wie der Name schon impliziert, den Lifecycle eines Operator zu managen. Der Operator Lifecycle Manager ist in der OpenShift4 Console integriert, kann aber auch Standalone betrieben werden. Red Hat will zukünftig auch eine Plattform/Markplatz bieten, um Vendor Neutral Operator bereitzustellen. Somit können OpenShift Betreiber diese in ihrem Umfeld einsetzen. Eine Liste von Operators ist hier zu finden. Darin sind nicht nur Operator basierend auf dem Operator Framework von Red Hat zu finden, sondern auch viele von anderen Herstellern. Auch Puzzle hat bereits einen Kubernetes Operator für Cryptopus geschrieben.

- Operator Metering Operator metering is responsible for collecting metrics and other information about what’s happening in a Kubernetes cluster, and providing a way to create reports on the collected data.

Weitere Informationen dazu sind u.A. hier zu finden. Ich selbst habe mich mit dem Thema aber noch nicht weiter beschäftigt.

Für weitere Informationen zum Operator Framework kann ich folgende Talks empfehlen:

- Intro: Operator Framework BoF – Diane Mueller & Sebastian Pahl, Red Hat

- Deep Dive: Operator Framework BoF – Diane Mueller & Sebastian Pahl, Red Hat

- State of Operators: Framework, SDKs, & beyond Sébastien Pahl Red Hat OpenShift Commons Gathering 2018

Weitere Talks zu sonstigen Kubernetes Operators:

- Keynote: Smooth Operator♪: Large Scale Automated Storage with… – Celina Ward & Matt Schallert

- Custom Controllers to the Rescue: Tailoring API Objects to Your… – Stephen Chan & Davi Arnaut

- Using a Kubernetes Operator to Manage Application Tenancy in a B2B SaaS App – Mike Arpaia, Kolide

- Managing Addons with Operators (Or How We Dropped Untested… – Jeff Johnson & Justin Santa Barbara

- Building your own PostgreSQL-as-a-Service on Kubernetes. – Alexander Kukushkin, Zalando SE

OpenShift 4

Am Co-Located OpenShift Commons Gathering Event am Montag hat Red Hat den aktuellen Entwicklungsstand von OpenShift 4 gezeigt.

Eine der grossen Änderungen in OpenShift 4 ist der komplett neu geschriebene Installer. Red Hat vereinfacht die Installation stark, im Vergleich zum Ansible Setup von OpenShift3. Die neue Philosophie von Red Hat ist „Quick success and adopt later“. Ein Cluster soll möglichst einfach und schnell aufgebaut werden können und erst anschliessend für die eigenen Bedürfnisse angepasst werden. Mit Ansible war das eher umgekehrt. Der neue Installer beinhaltet unter anderem auch Hashicorp Terraform.

Weiter setzt Red Hat mit OpenShift4 vollständig auf das Operator Framework. Eine OpenShift4 Instanz wird komplett mit Operators gemanaged. Sämtliche Maintenance Tasks, Updates etc werden über den Operator gesteuert. Nach der Installation von OpenShift4 wird der Installer nicht mehr benötigt.

Eine Demonstration des neuen OpenShift Installer ist im Talk OpenShift 4.0 – Features, Functions, Future at OpenShift Commons Gathering Seattle 2018 zusehen. Wer Interesse hat, kann es auch selbst unter https://try.openshift.com/ ausprobieren.

P.S.: Puzzle hat es sogar geschafft, auf eine der Slides am OpenShift Common Gathering zu kommen 🙂

ServiceMesh

Das Thema ServiceMesh war praktisch überall wichtig und präsent. Mit dem Trend zu Microarchitecture wird auch das Thema Service Mesh zentral. Doch was ist eigentlich ein Service Mesh?

A service mesh is a configurable infrastructure layer for a microservices application. It makes communication between service instances flexible, reliable, and fast. The mesh provides service discovery, load balancing, encryption, authentication and authorization, support for the circuit breaker pattern, and other capabilities.

Die bekannten Player sind hier:

- Linkerd

- Envoy Proxy

- Istio wobei die Grundlage hier auch Envoy Proxy ist

Um mehr über Service Meshs und die erwähnten Produkte zu erfahren, empfehle ich die folgenden Talks:

- Keynote: Envoy Update – Matt Klein, Senior Software Engineer, Constance Caramanolis

- Intro: Envoy – Matt Klein & Constance Caramanolis, Lyft

- Deep Dive: Envoy – Matt Klein & Constance Caramanolis, Lyft

- Linkerd 2.0, Now with Extra Prometheus – Andrew Seigner, Buoyant & Frederic Branczyk, CoreOS

- Tutorial: Using Istio – Lee Calcote & Girish Ranganathan, SolarWinds

- Securing Application Telemetry & Tracing with SPIFFE and Envoy – Sabree Blackmon, Docker

- Deep Dive: Linkerd – Oliver Gould, Buoyant

- Istio – The Packet’s-Eye View – Matt Turner, Tetrate

- Service Meshes: The Production Readiness Checklist for the Rest… – Zachary Arnold & Austin Adams

- Is Istio the Most Next Gen Next Gen Firewall Ever Created? – John Morello, Twistlock

- Evolution of Integration and Microservices with Service Mesh and Ballerina – Christian Posta

Serverless & kNative

Serverless computing is a cloud-computing execution model in which the cloud provider acts as the server, dynamically managing the allocation of machine resources. Pricing is based on the actual amount of resources consumed by an application, rather than on pre-purchased units of capacity. It is a form of utility computing.

The name „serverless computing“ is used because the server management and capacity planning decisions are completely hidden from the developer or operator. Serverless code can be used in conjunction with code deployed in traditional styles, such as microservices. Alternatively, applications can be written to be purely serverless and use no provisioned servers at all. https://en.wikipedia.org/wiki/Serverless_computing

kNative ist eine Kubernetes basierte Plattform zum Bilden, Deployen und Managen von modernen serverless Workloads. Key Features der von Google entwickelten Plattform sind:

- Serving, Scale to zero, request-driven compute model

- Build, Cloud-native source to container orchestration

- Events, Universal subscription, delivery and management of events

- Serverless add-on on GKE, Enable GCP managed serverless stack on Kubernetes

Viele Anbieter, darunter auch Red Hat, integrieren zur Zeit kNative. Ich gebe davon aus, dass kNative in Zukunft eines der Key-Elemente von Kubernetes sein wird.

Ein paar Talks zu diesem Thema

- Keynote: Kubernetes, Istio, Knative: The New Open Cloud Stack – Aparna Sinh

- Intro: Knative Productivity BoF – Srinivas V. Hegde & Adriano Cunha, Google

- Tutorial: Getting Your Hands Dirty with Knative – Bas Tichelaar & Adé Mochtar, Instruqt

- Machine Learning Model Serving and Pipeline Using KNative – Animesh Singh & Tommy Li, IBM

- Building Container Images on Your Kubernetes Cluster with Knative Build – Gareth Rushgrove, Docker

- How to Build Deep Learning Inference Through Knative Server… – Huamin Chen & Yehuda Sadeh-Weinraub

- T-Mobile Store Locator Serverless Journey with Knative and Kubernetes – Ram Gopinathan, T-Mobile

- Deep Dive: Knative Productivity BoF – Jessie Zhu & Adriano Cunha, Google

- Knative: Scaling From 0 to Infinity – Joseph Burnett & Mark Chmarny, Google

- Birds of a Feather: Knative – Jessie Zhu, Google

P.S.: Phippy goes to the Zoo

Wer auf einfache Weise erklären will, was Kubernetes ist, der soll sich doch mal Phippy goes to the Zoo anschauen.